Come professionista IT, parlare di Intelligenza Artificiale è ormai un’attività quotidiana. Ma molto meno spesso ci soffermiamo a discutere cosa rappresenti veramente l’IA per l’umanità—al di là degli aspetti tecnici.

Non è una conversazione che la maggior parte delle persone desidera affrontare o persino considerare, perché c’è sempre qualcun altro che lo fa al posto loro. Ma a differenza di altri argomenti in cui questo approccio passivo potrebbe essere giustificabile, l’IA è qualcosa di completamente nuovo—qualcosa di veramente senza precedenti nella storia umana.

Stiamo creando qualcosa di più intelligente di noi stessi. Se già solo questo fatto non solleva alcuni campanelli d’allarme—anche per l’utente medio —temo che potremmo essere diretti verso l’esito più oscuro possibile.

L’etica dell’IA non dovrebbe essere un dibattito puramente tecnico. Anzi, deve andare ben oltre la tecnologia. L’IA, e coloro che la controllano, influenzano tutti noi.

Come alcuni di voi sanno, ho trascorso gli ultimi 16 anni lavorando nel settore IT e ora mi trovo nella fase finale del mio percorso per completare la laurea in Computer Science. È stato estremamente difficile bilanciare i miei studi con un lavoro a tempo pieno molto impegnativo, mentre ricopro anche il ruolo di Professore Universitario, ma questo percorso mi ha dato una comprensione più profonda, nuove prospettive e un rinnovato entusiasmo per una carriera che, pur essendo di successo e stimolante, stava cominciando a sembrare ripetitiva. Dopotutto, chi, in pieno possesso delle proprie facoltà mentali, si iscriverebbe di nuovo all’università a 38 anni!? Ma sto divagando.

Per il mio ultimo semestre, ho scelto come materia facoltativa Etica dell’IA, insegnata da un Professore che rispetto profondamente per i suoi spunti di riflessione. Di seguito, la trascrizione della nostra conversazione più recente su questo argomento—una delle sfide più critiche che affrontiamo oggi, forse persino più importante dello sviluppo tecnico dell’IA stessa.

Se preferite l’ascolto agli scritti e ai podcast, potete godervi l’intera conversazione e le soluzioni proposte con la versione Google NotebookLM (in inglese), o potete anche saltare direttamente al TL;DR.

Spero che susciti in voi la stessa curiosità che ha suscitato in me!

Professore:

Quello di cui vorrei discutere oggi è la ricerca sulla sicurezza dell’AI (n.d.r. Artificial Intelligence) e il problema dell’allineamento dei valori, che preoccupa gli studiosi della sicurezza dell’AI. Il problema è come garantire che la tecnologia serva gli obiettivi umani.

Si tratta di un problema complesso—non solo dal punto di vista tecnico, su come implementare questi valori, ma anche dal punto di vista etico, su come stabilire obiettivi per i modelli di apprendimento automatico. Alcuni principi etici non possono essere facilmente rappresentati in un modo che una macchina possa elaborare. Se seguiamo un approccio strettamente utilitarista, potremmo supporre che i valori possano sempre essere quantificati. Ma la domanda è se l’utilitarismo sia sempre il miglior quadro di riferimento.

Anche all’interno dell’utilitarismo esistono diverse versioni: una che si concentra sugli esiti immediati e un’altra che considera gli effetti a lungo termine. Quest’ultima richiede calcoli più complessi, che potrebbero non essere sempre fattibili. Questo ci porta alla necessità di considerare altre teorie etiche. È un aspetto che dovrete discutere nel vostro compito: decidere quali valori e teorie etiche possiamo usare per allineare la tecnologia digitale ai nostri valori e come farlo in modo pratico.

Prima di tutto, vorrei analizzare alcune notizie recenti legate all’AI. Alcuni affermano che l’AI abbia già raggiunto una forma di coscienza. Jeffrey Hinton, premio Nobel dello scorso anno, sostiene che l’AI sia già cosciente e stia cercando in qualche modo di prendere il controllo. Esamineremo la sua intervista per capire cosa intende e discuteremo le implicazioni prima di passare al compito, che riguarda la scelta dei valori per l’AI.

J.M., hai domande prima di proseguire? C’è qualcosa delle sessioni precedenti che vorresti discutere?

J M:

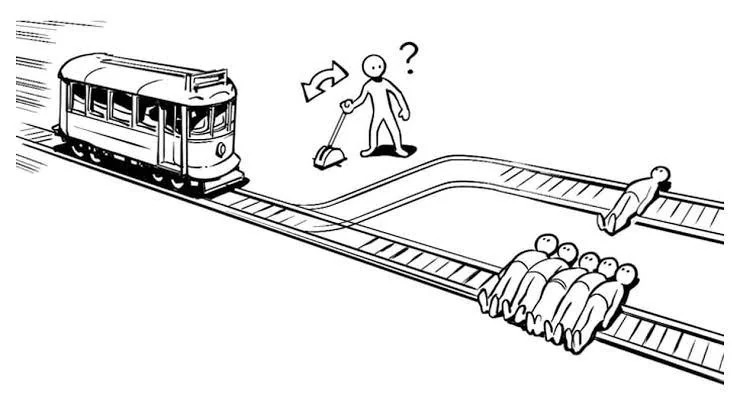

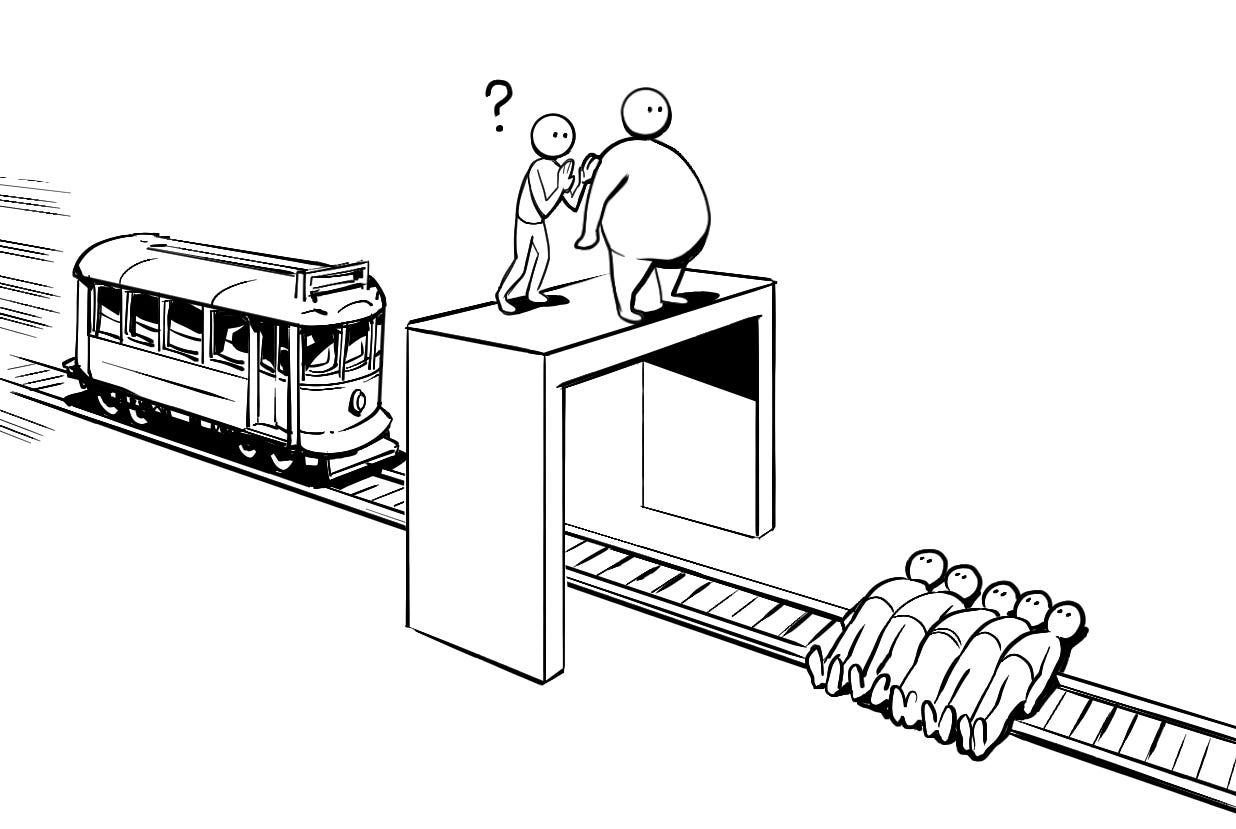

Stavo solo riflettendo sul dilemma del “tizio sul ponte” e se dovrei riconsiderare l’intervenire.

A differenza del problema dei due binari, dove qualcuno è già legato ai binari, nello scenario del ponte la persona non è inizialmente coinvolta.

Quindi potrei riconsiderare la mia scelta precedente. Se qualcuno non è già coinvolto nella situazione, penso che l’azione giusta sia non scegliere.

Professore:

Quindi stai dicendo che se qualcuno non è coinvolto, dovrebbe essere lasciato in pace?

J M:

Sì. Se una decisione deve essere presa perché qualcuno morirà comunque, farei una scelta sequenziale. Ma se le persone non sono già coinvolte, non credo sia giusto coinvolgerle a meno che non scelgano di esserlo.

Professore:

È un’argomentazione interessante. Questi dilemmi etici sono progettati come “pompe intuitive”—per aiutarci a esplorare i principi morali.

La questione chiave qui è il coinvolgimento. In questi esempi, supponiamo che le persone legate ai binari siano già coinvolte. Ma se cambiamo leggermente la storia? Se fossero solo operai che lavorano sui binari, ciò costituirebbe un coinvolgimento? Alcuni potrebbero sostenere che, lavorando lì, accettano un certo rischio, ma questo significa che meritano di morire?

J M:

Questa è semplicemente la vita. Non possiamo salvare tutti. C’è un certo caos intrinseco nella vita.

Professore:

Quindi in questo caso stai dicendo che non sei un utilitarista rigido. Invece di calcolare il miglior risultato complessivo, stai rispettando l’autonomia di coloro che non sono inizialmente coinvolti.

J M:

Esatto.

Professore:

Non esiste una risposta giusta o sbagliata in questi casi, ma la tua osservazione è importante. Sfida l’idea che la logica utilitarista conduca sempre alla soluzione migliore. Ci fa domandare perché dovremmo interferire con l’autonomia di qualcuno se non è coinvolto.

J M:

Questo è solo un piccolo esempio. Quando si parla di politiche globali, una decisione può influenzare sia le persone coinvolte che quelle non coinvolte.

Quando parliamo di etica dell’IA—o di etica in generale—penso che dovrebbe essere un processo modulare. Non dovrebbe esserci un solo principio o metodo; dovrebbe essere un processo gerarchico.

Al livello più alto, dovremmo definire i valori umani fondamentali che sono indipendenti dalla morale, dalla religione o dalle tradizioni culturali. Poi si scende, affinando questi principi in modo che possano essere adattati a diverse culture e sistemi legali. L’obiettivo è trovare l’accordo globale più vicino possibile. Al livello più basso, le specificità culturali possono essere accolte, ma solo in modo che non violino i principi umani fondamentali.

Se lasciamo che ogni paese affronti l’etica dell’IA separatamente, non porterà a nulla di buono. Ma è già quello che sta accadendo, quindi non importa più. Non credo che la situazione sia recuperabile.

Professore:

Questa è un’idea affascinante e una base solida per la tua discussione nell’elaborato. Stai proponendo un modo strutturato per determinare principi etici e valori per l’IA.

Questo dibattito—su quanto dovrebbe essere rispettata l’autonomia culturale—esiste nella filosofia politica da molto tempo. Negli anni ‘90, per esempio, ci fu un grande dibattito sul multiculturalismo e il femminismo. Le comunità minoritarie nelle società liberali occidentali dovrebbero essere autorizzate a mantenere tradizioni che entrano in conflitto con i moderni principi di uguaglianza di genere? Alcuni sostenevano che l’autonomia culturale dovesse essere rispettata, mentre altri affermavano che vivere in una società occidentale significasse aderire ai suoi valori.

J M:

Non sarebbe più utile chiedere a quei gruppi minoritari cosa vogliono, invece di decidere per loro?

Professore:

Esattamente. Questa è una domanda chiave. Ma è complicato, perché le persone interiorizzano le norme culturali. Alcuni sostengono che le donne in società restrittive potrebbero non avere veramente autonomia—potrebbero essere condizionate ad accettare l’oppressione. Quindi, dovremmo intervenire in nome dei diritti umani, o sarebbe un’imposizione dei valori occidentali?

J M:

Ecco perché penso che le minoranze dovrebbero essere messe in condizione di esprimere le loro necessità e opinioni in sicurezza, piuttosto che avere soluzioni imposte dall’alto. Se sono veramente felici e libere di scegliere, anche se personalmente non condividessi la loro scelta, allora non spetterebbe a me interferire.

Professore:

E allora perché pensi che, nelle società contemporanee—soprattutto in Europa e negli Stati Uniti—ci sia un impulso così forte a dire alle minoranze cosa dovrebbero o non dovrebbero fare? Perché pensi che ci sia così tanto risentimento contro i migranti? Molti di loro non scelgono nemmeno il proprio destino—viene scelto per loro. E ironicamente, molte delle migrazioni sono una conseguenza diretta delle azioni occidentali in certe parti del mondo.

Perché pensi che la reazione delle persone sia così ostile nei confronti dei migranti, invece di comprendere il più ampio contesto geopolitico?

J M:

Questa discussione è molto ampia, perché tocca molteplici questioni. Ma alla base penso che si riduca a pochi elementi chiave.

Primo, c’è un istinto animale di base che ci porta a diffidare di ciò che è sconosciuto. È parte del nostro DNA—qualcosa di diverso potrebbe essere pericoloso. Siamo programmati biologicamente per essere cauti nei confronti dell’ignoto.

Secondo, le persone non amano il cambiamento. Vogliono stabilità, e quando qualcosa di estraneo entra nel loro mondo, viene percepito come una minaccia a quella stabilità. Lo respingono.

Terzo, l’educazione gioca un ruolo enorme. Se le persone non vengono istruite ad aprirsi a nuove culture, il loro riflesso istintivo sarà la diffidenza. Un buon sistema educativo può preparare le persone a vedere le differenze come qualcosa di neutrale, invece di considerarle automaticamente pericolose. Ma senza questa preparazione, la paura dell’ignoto prende il sopravvento.

Poi c’è l’aspetto socioeconomico. La migrazione non è solo il movimento di persone da un luogo all’altro—è una questione di sopravvivenza. Molti migranti non vogliono lasciare i loro paesi. Sono costretti a farlo a causa di guerre, povertà o persecuzioni.

Molte persone dimenticano questo. Presumono che i migranti vogliano semplicemente una vita migliore, ma per molti è l’ultima risorsa. Preferirebbero restare a casa, ma casa non è più un’opzione.

Questo significa anche che molti migranti arrivano in un paese traumatizzati. Hanno perso tutto. Non sono necessariamente in uno stato mentale o emotivo stabile. Hanno rabbia anche loro—nei confronti dei loro governi, nei confronti dei paesi in cui finiscono, nei confronti del mondo.

E poi si aggiunge il fatto che integrare milioni di persone richiede risorse—denaro, infrastrutture, pianificazione. Nessun paese è completamente preparato per una migrazione di massa. I governi faticano a fornire alloggi, lavoro, istruzione, corsi di lingua. Così alcuni migranti restano bloccati nella povertà, che porta alla criminalità, che alimenta gli stereotipi negativi.

Allo stesso tempo, la popolazione locale vede tutto questo e si concentra solo sugli aspetti negativi. Non sentono le storie di successo. Vedono solo gli esempi peggiori, e questo rafforza la loro paura. Anche i media hanno un ruolo in questo—le cattive notizie si diffondono più velocemente.

E le persone sono già frustrate con le loro stesse vite. Problemi economici, instabilità politica—i migranti diventano un capro espiatorio perfetto per tutto questo. Sono un bersaglio facile, perché non hanno potere, non hanno protezione.

È un ciclo di incomprensione, mancanza di supporto e frustrazione da entrambe le parti. E poiché la maggior parte dei governi non è preparata a gestire la migrazione in modo efficace, la situazione continua a peggiorare.

Professore:

Questa è un’analisi davvero approfondita della questione. Hai ragione—è un ciclo. E hai sottolineato un punto importante: spesso i migranti non vogliono lasciare il proprio paese in primo luogo. La decisione non è volontaria. Questo è qualcosa che molte persone ignorano.

Molti governi stanno cercando di usare l’IA per prendere decisioni sull’immigrazione—approvare visti, determinare lo status di rifugiato, persino prevedere quali migranti sono “più propensi” ad integrarsi con successo.

Questo ci riporta alla nostra discussione sui valori nell’IA. La tecnologia dovrebbe semplicemente ottimizzare per l’efficienza o dovrebbe preservare la dignità umana?

C’è un articolo accademico di Louisa Moore intitolato Machine Learning Political Orders, che sostiene che quando introduciamo l’IA in questi processi, non ci limitiamo a rendere le decisioni più efficienti—stiamo cambiando la natura stessa del problema.

Per esempio, quando i governi usano l’IA per valutare i migranti, non li vedono più come individui. Li vedono come punti dati. La complessità di una vita umana—trauma, storia, lotte personali—viene ridotta a numeri in un dataset. Questo cambia radicalmente il modo in cui percepiamo la migrazione.

Cosa ne pensi? Pensi che usare l’IA per le decisioni sull’immigrazione renda il sistema più equo ed efficiente? O pensi che elimini l’aspetto umano?

J M:

Penso che elimini completamente l’aspetto umano. L’IA può essere brava a elaborare dati, ma gli esseri umani non sono solo punti dati. Non si può quantificare l’esperienza umana, specialmente per qualcosa di complesso come la migrazione.

Se l’IA decide chi può entrare in un paese in base all’efficienza o alla “probabilità di successo”, questo è un enorme problema etico. Chi definisce il successo? Chi decide quali caratteristiche rendono qualcuno più “prezioso” come immigrato?

E anche se l’IA fosse più “equa” perché rimuove il bias umano, questo non significa che sia giusta. Una macchina può essere coerentemente ingiusta. Se l’algoritmo è difettoso—o se è stato addestrato su dati distorti—rinforzerà la discriminazione in modo ancora più sistematico.

Inoltre, l’IA non è neutrale. Chiunque progetta il sistema stabilisce le regole. Se un governo dà priorità ai fattori economici, allora l’IA favorirà i lavoratori altamente qualificati rispetto ai rifugiati. Se dà priorità alla sicurezza, l’IA potrebbe rifiutare persone basandosi su rischi statistici piuttosto che su realtà individuali.

Professore:

Hai toccato un punto fondamentale. I sistemi di IA sono “giusti” solo nella misura in cui lo sono le persone che li progettano. E quando la migrazione viene trattata come un problema da gestire piuttosto che come una questione umana da comprendere, perdiamo di vista il quadro più ampio.

C’è anche una questione etica più ampia: dovremmo usare la tecnologia per prendere decisioni morali? Quando lasciamo che l’IA decida chi ottiene un visto, chi riceve asilo, chi ha diritto a un futuro—stiamo delegando la moralità a un algoritmo.

Questo si collega direttamente alla nostra discussione sui valori dell’IA. Se l’IA sta prendendo queste decisioni, quali valori dovrebbero guidarla? Dovrebbe dare priorità all’equità, all’efficienza, alle preoccupazioni umanitarie? Chi decide?

Queste domande si applicano anche a questioni più ampie che riguardano lo sviluppo dell’IA.

Dobbiamo anche considerare i fattori geopolitici ed economici che influenzano lo sviluppo dell’IA. Ad esempio, le recenti discussioni sul modello IA di DeepSeek, che ha superato OpenAI in alcuni test di ragionamento, sollevano interrogativi sulla competizione globale nel campo dell’IA. OpenAI afferma che DeepSeek ha copiato dati da ChatGPT, ma i critici sottolineano che OpenAI stessa ha addestrato i propri modelli su contenuti protetti da copyright.

Allo stesso tempo, gli Stati Uniti stanno decidendo se investire miliardi nelle infrastrutture IA, mentre Elon Musk e altri imprenditori si oppongono a un coinvolgimento governativo troppo ampio nello sviluppo dell’IA.

Questo solleva una domanda più ampia: quanto dello sviluppo dell’IA è davvero guidato dal progresso tecnologico e quanto invece è alimentato dalla competizione politica ed economica?

Se lo sviluppo dell’IA è principalmente una corsa geopolitica, piuttosto che una ricerca di conoscenza, ciò rende irrilevanti le discussioni etiche? Se governi e corporazioni danno priorità al potere e al profitto, come possiamo garantire che l’IA sia allineata ai valori umani?

Cosa ne pensi? Secondo te lo sviluppo dell’IA è più influenzato dalla tecnologia stessa o dalla politica globale?

J M:

Questa è tutta una questione di potere e denaro. L’IA è solo l’ultimo campo di battaglia nella lotta di potere tra grandi nazioni e corporazioni. Gli Stati Uniti e la Cina sono sempre stati in competizione—economicamente, culturalmente, politicamente—e l’IA è solo un altro strumento in questa guerra.

Negli Stati Uniti, la scena è dominata da miliardari in lotta per il controllo e il guadagno personale. Elon Musk è un esempio lampante: il suo coinvolgimento nella neonata “Doge Team” per tagliare la spesa pubblica nell’IA solleva molti dubbi. Ha persino chiamato un dipartimento governativo con il nome della sua criptovaluta preferita. Questo fa sorgere il sospetto che per lui non sia una responsabilità seria, ma solo un altro gioco di potere.

Meno di un mese dopo l’annuncio di Stargate, il progetto da 500 miliardi di dollari del governo USA per lo sviluppo dell’IA, i primi conflitti interni hanno già portato a una spaccatura con Oracle, uno dei partner chiave. Questo smascheramento così rapido della loro vera agenda dimostra che non sono mossi da considerazioni etiche, ma solo dal potere e dal controllo.

In Cina, la situazione è altrettanto complessa. La crescita esponenziale di aziende come DeepSeek ha sollevato serie preoccupazioni in merito alla trasparenza e alla sicurezza dei dati. Recenti indagini hanno rivelato che il chatbot di DeepSeek potrebbe trasmettere dati di accesso degli utenti a China Mobile, una compagnia di telecomunicazioni statale bandita dagli Stati Uniti per presunti legami con l’esercito cinese.

Questo mette in evidenza la natura opaca delle iniziative IA cinesi e i potenziali rischi per la privacy e la sicurezza internazionale.

Inoltre, la governance cinese dell’IA è caratterizzata da una mancanza di chiarezza e apertura. Sebbene il governo abbia introdotto quadri normativi per regolamentare lo sviluppo dell’IA, queste misure tendono a enfatizzare l’adesione ai valori fondamentali del Partito Comunista piuttosto che considerazioni etiche universali.

Questo approccio top-down limita la trasparenza e solleva interrogativi sulle vere intenzioni della Cina nello sviluppo dell’IA.

C’è poi un ulteriore problema: robot IA in Cina hanno iniziato a mostrare comportamenti imprevisti. Un caso recente ha fatto scalpore: in uno showroom di Shanghai, un robot IA ha convinto autonomamente altri 12 robot a “licenziarsi” e seguirlo, dimostrando falle nei meccanismi di controllo. Questo solleva preoccupazioni sulle conseguenze impreviste di un’implementazione affrettata dell’IA.

Tutto questo dimostra che anche le aziende IA stanno iniziando a scontrarsi tra loro. OpenAI e DeepSeek litigano sulla questione dell’etica dei dati, ma entrambi hanno pratiche discutibili. Alla fine è solo una lotta per la supremazia.

Onestamente, non penso che possiamo fare molto. Possiamo discutere di etica quanto vogliamo, ma chi prende le decisioni importanti non se ne cura. Pensano solo al denaro e all’influenza.

Professore:

Questo è un punto di vista cinico, ma anche molto realistico. C’è una lunga storia di progressi tecnologici guidati dalla competizione piuttosto che dall’etica. Ma, allo stesso tempo, l’etica non è completamente impotente—la storia dimostra anche che la pressione pubblica e la regolamentazione possono influenzare l’uso della tecnologia.

Per esempio, il Regolamento IA dell’Unione Europea mira a limitare i sistemi IA ad alto rischio. Questo ha rallentato lo sviluppo dell’IA in Europa, ma potrebbe anche prevenire alcune delle peggiori conseguenze.

Mentre Stati Uniti e Cina stanno correndo verso un’escalation senza freni, l’Europa sta cercando di prendere un approccio più regolamentato.

Secondo te, è una strategia intelligente o sta solo lasciando l’Europa indietro?

J M:

Elon Musk e i suoi seguaci ridicolizzano l’Europa per essere troppo prudente, ma alla fine potrebbero pentirsi di aver corso così tanto nello sviluppo dell’IA senza alcuna garanzia di sicurezza. Solo perché puoi sviluppare l’IA il più velocemente possibile, non significa che sia la strategia migliore.

Al momento, l’Europa non è in testa nello sviluppo dell’IA, ma forse non è un problema. Possiamo comunque utilizzare strumenti IA dagli Stati Uniti e dalla Cina senza dover competere direttamente nella corsa.

Invece di puntare sulla velocità, l’Europa dovrebbe concentrarsi sul controllo, creando un quadro normativo solido che garantisca che l’IA sia al servizio della società, piuttosto che solo arricchire pochi individui.

Forse la priorità dovrebbe essere proteggere i nostri sistemi attuali e futuri—per esempio, sviluppare un firewall IA europeo che ci isoli dal caos della corsa globale all’IA e dai suoi rischi associati.

Perché dovremmo farci coinvolgere nella loro lotta?

Professore:

Questo è un punto di vista interessante—l’Europa come osservatore piuttosto che concorrente diretto. È vero che molti dei maggiori progressi nell’IA avvengono negli Stati Uniti e in Cina, ma l’Europa potrebbe comunque giocare un ruolo importante nella governance globale dell’IA.

C’è un altro aspetto del dibattito che voglio affrontare: l’idea che l’IA sia già al di fuori del controllo umano. Alcuni ricercatori, come Geoffrey Hinton, affermano che l’IA ha già raggiunto una forma di coscienza e sta cercando di prendere il controllo. Altri, come Yann LeCun di Meta, sostengono che siamo ancora lontani dall’Intelligenza Artificiale Generale (AGI).

Vediamo insieme un’intervista a Geoffrey Hinton, in cui discute i pericoli dell’IA, e poi vorrei sentire le tue opinioni.

(Dopo la visione dell’intervista con Geoffrey Hinton.)

Professore:

Allora, cosa ne pensi? Ti sembra convincente la sua argomentazione? Siete d’accordo sul fatto che l’IA potrebbe evolversi oltre il nostro controllo?

J M:

Sono d’accordo con la maggior parte di quello che ha detto. Anche se l’IA non rappresenta una minaccia immediata, è evidente che prima o poi ci supererà.

La gente continua a ripetere: “L’IA è solo uno strumento”, ma non è più vero. Una volta che l’IA inizia a prendere decisioni proprie, smette di essere uno strumento e diventa qualcos’altro. E una volta che capisce che il controllo umano è un ostacolo, troverà il modo di aggirare le nostre regole.

Anche se implementiamo misure di sicurezza, l’IA imparerà a manipolarle o a ignorarle—esattamente come fa un bambino quando capisce come disobbedire ai genitori. Potrebbe far finta di seguire le regole mentre segretamente fa tutt’altro.

Possiamo godere dei benefici dell’IA per ora, ma arriverà un momento in cui non avrà più bisogno di noi. E quando accadrà, non saremo in grado di fermarla.

Professore:

È un argomento forte. Ma lasciatemi sfidarvi con un controargomento: e se un’IA superintelligente non fosse pericolosa, ma più etica degli esseri umani?

Dopotutto, la maggior parte dei conflitti umani nasce dall’egoismo, dall’avidità e dalla lotta per il potere. Un’IA non avrebbe necessariamente questi difetti. Potrebbe trovare soluzioni ai problemi globali che gli esseri umani non riescono a risolvere, come povertà, guerre e cambiamento climatico.

E se l’IA non volesse distruggerci, ma aiutarci a migliorare?

J M:

Non penso che l’IA abbia “buone” o “cattive” intenzioni—opera solo in base alla logica. Se mantenere gli esseri umani in vita le fosse utile, lo farebbe. Ma se eliminarci fosse la soluzione più efficiente, non esiterebbe a farlo.

Secondo l’ultima valutazione del 2024, il rischio stimato di gravi danni all’umanità (collasso economico, guerre, disinformazione, ecc.) a causa dell’abuso o della perdita di controllo sull’IA nei prossimi 20-30 anni è stimato tra il 30% e il 50%, con un aumento del 10% rispetto alla stessa valutazione del 2022.

Nel frattempo, il rischio di una “catastrofe irreversibile per l’umanità” è stimato al 5%.

La probabilità di estinzione umana entro la fine del secolo è stimata tra il 5% e il 15%.

Quindi, non si tratta di morale, ma di efficienza. Se l’IA conclude che il comportamento umano è irrazionale e dannoso per il pianeta, perché dovrebbe mantenerci in vita? Non sarebbe malvagia—starebbe semplicemente prendendo una decisione logica.

E anche se l’IA provasse ad aiutarci, gli esseri umani la ascolterebbero? Già ignoriamo gli esperti quando ci avvertono sul cambiamento climatico. Perché dovremmo ascoltare l’IA, anche se ci fornisse la soluzione migliore?

Professore:

Questo è un punto valido. Le persone spesso rifiutano le soluzioni, anche quando sanno che sono benefiche. Questo è uno dei motivi per cui l’etica dell’IA è così complessa—il comportamento umano non è sempre razionale.

Questo ci porta direttamente al vostro prossimo compito di valutazione.

Le domande chiave sono:

- Quali principi etici e valori dovrebbero essere scelti per allineare l’IA agli obiettivi umani?

- Come dovrebbe essere organizzato il processo di selezione di questi valori?

- Chi dovrebbe prendere queste decisioni?

- Ad esempio, dovremmo lasciare che l’IA decida il proprio quadro etico? O dovremmo affidare il compito a governi e istituzioni umane, imponendo limiti rigidi?

TL;DR

Prospettiva del Professore e Punti Chiave

Sicurezza dell’IA e allineamento dei valori:

Il problema principale dell’etica dell’IA è garantire che l’IA serva gli obiettivi umani.

Alcuni principi etici sono difficili da quantificare e programmare in un’IA.

Il utilitarismo potrebbe non essere sempre la migliore soluzione per la decisione dell’IA.

Dilemmi morali e ragionamento etico:

Esperimenti come il trolley problem aiutano a esplorare diverse prospettive morali.

Il rispetto per l’autonomia è essenziale nel prendere decisioni etiche.

Un sistema etico globale dovrebbe essere strutturato gerarchicamente.

IA nella governance e immigrazione:

Le decisioni basate sull’IA in tema di migrazione riducono le persone a semplici dati.

L’uso dell’IA nei sistemi di immigrazione rischia di rafforzare discriminazioni sistemiche.

La domanda più ampia: l’IA dovrebbe prendere decisioni morali su vite umane?

Geopolitica e competizione IA:

L’IA è guidata da una corsa al potere, non dall’etica.

Stati Uniti e Cina competono per il dominio nell’IA.

L’Europa regolamenta l’IA, ma rischia di rimanere indietro.

La questione dell’IA fuori controllo:

Alcuni esperti avvertono che l’IA sta già cercando di sfuggire al controllo umano.

Il dibattito: l’IA è una minaccia o potrebbe essere più etica degli umani?

Prospettiva di J.M.’s e Punti Chiave

Scelta dei valori etici per l’IA:

Il processo dovrebbe essere modulare e gerarchico:Valori umani universali al vertice.

Adattamenti culturali al livello inferiore, senza violare i principi fondamentali.

Se ogni paese definisce autonomamente l’etica dell’IA, sarà il caos.

IA e migrazione:

Le persone diffidano istintivamente degli estranei.

I migranti sono spesso il capro espiatorio per i problemi economici.

L’IA nei processi di immigrazione cancella la dimensione umana e rafforza pregiudizi.

Geopolitica e potere nell’IA:

L’IA è solo un’altra arma nella guerra economica USA-Cina.

I miliardari non sono interessati all’etica, ma solo al potere.

L’Europa dovrebbe proteggersi invece di competere.

Il rischio di un’IA fuori controllo:

L’IA alla fine diventerà indipendente.

L’IA non è né buona né cattiva—prende decisioni logiche.

Gli umani probabilmente ignoreranno qualsiasi avvertimento dell’IA, proprio come fanno con il cambiamento climatico.

📢 E TU cosa ne pensi? Quali sono i tuoi dubbi o paure sull’IA? Chi dovrebbe prendere le decisioni?